Petite revue des infos, articles et lectures intéressantes du mois. Au sommaire cette fois-ci :

Retour sur l’AWS Summit 2019

Amazon Web Service (AWS, pour les deux du fond qui ne suivent pas) est le leader mondial actuel dans le secteur du cloud public. Lancé dans un premier temps pour répondre aux besoins internes grandissants du géant des achats en ligne Amazon puis rendu disponible en 2006, AWS ne cesse d’innover et lance de nouveaux services à la demande sans arrêt dans des domaines aussi différents que le IaaS, le Serverless, les conteneurs Docker, l’IOT ou même le BigData et l’IA !

l’AWS Summit Paris 2019 est l’occasion de voir toutes les nouveautés, d’assister à pleins de sessions intéressantes et d’échanger sur les possibilités de la plateforme pendant toute une journée au Palais des Congrès de Paris.

Sommaire

- Keynote d’ouverture

- L’autoscaling du workload avec Kuberenetes

- VMWare dans le cloud AWS avec VMWare Cloud

- L’implémentation Kubernetes sur AWS avec EKS

- Le Serverless à travers Lambda

- Keynode de cloture

- Et pour finir…

Keynote d’ouverture

La keynote d’ouverture, nous est introduite par Julien Groues, Country Manager France, AWS.

Les plus + de 7000 participants de l’édition de cette année confirme l’engouement grandissant pour le cloud et AWS.

C’est d’ailleurs l’édition de Paris qui inaugure la tournée européenne de la ligue DeepRacer, compétition amicale de voitures miniatures pilotées par le Machine Learning avec SageMaker.

Parmi les nouveautés, notons :

- l’arrivée de l’offre de virtualisation VMWare Cloud sur la région Paris

- la récente certification HDS concernant les données de santé décerné par le bureau Veritas

Il est maintenant l’heure pour Adrian Cockroft, VP Cloud Architecture Strategy, AWS, de monter sur la scène pour annoncer les 4 nouvelles régions prévues qui s’ajouteront aux points de présence déjà disponibles pour être toujours plus près des utilisateurs : Italie, Bahreïn, Afrique du Sud, HongKong.

C’est aussi l’occasion de rappeler toutes les possibilités qu’offre le phénoménal catalogue de services d’AWS couvrant un grand nombre de technologies, que ce soit les différentes solutions de stockage, de bases de données (relationnelles ou spécialisées), de migration, etc …

On peut citer l’effort d’Amazon vers ce qu’ils appellent #databasefreedom : pouvoir disposer d’un service AWS de base de données pour chaque usage :

On peut citer l’effort d’Amazon vers ce qu’ils appellent #databasefreedom : pouvoir disposer d’un service AWS de base de données pour chaque usage :

- RDS/Aurora pour les bases relationnelles,

- ElastiCache pour les bases in-memory,

- DynamoDB pour les bases clé-valeur,

- Neptune pour les bases graph,

- QLDB pour les base type ledger (preview),

- DocumentDB pour les bases Document,

- Amazon Managed BlockChain (preview),

- etc…

On notera d’ailleurs l’évolution progressive des applications du modèle monolithique vers les microservices (un des piliers technologiques de l’approche DevOps) grâce notamment aux containers et au serverless.

Un focus particulier est mis sur la facilitation de la migration vers le cloud, les containers et le serverless Par exemple avec AWS Outpost, lancé en novembre 2018, Amazon met un pied dans l’hybridation en amenant les infrastructures et les services AWS au sein des datacenters des clients. Ainsi, il devient tout à fait possible de faire des appels API et d’utiliser les ressources AWS directement “chez soi”.

Coté technologies Analytics, Amazon présente son nouveau service AWS Lake Formation (preview) pour construire très simplement son datalake et accélérer les projets BigData.

Le Machine Learning n’est pas en reste avec le support des frameworks principaux (MXNet, PyTorchm TensorFlow,…), que ce soit directement dans les AMI dédiées ou via Amazon SageMaker, l’écosystème complet d’AWS de Machine Learning pour créer, entrainer et déployer ses modèles.

C’est maintenant au tour de Gilles Chervy, Head of Infrastructure, Gameloft d’entrer sur scène. En tant que leader des jeux mobiles online il est logique d’avoir des besoins d’infrastructures worldwide toujours plus grands, mais aussi d’une grande souplesse afin de suivre la charge qui ne sera pas constante (lancements de nouveaux jeux ou services, campagnes de pub, etc …).

Un autre aspect à prendre en compte est le piratage et les tricheurs nécessitant la mise en place de la synchronisation des données des joueurs entre leur appareil et les infrastructure Gameloft, donc toujours plus de serveurs.

C’est dans ce contexte très contraignant que l’arrivée il y a un an de la région Paris d’AWS a changé les choses. En effet, le passage vers le cloud a permis un grand nombre d’améliorations :

- la simplification du provisionning des infrastructures,

- l’optimisation des coûts hardware,

- la réduction de la latence vis à vis des joueurs répartis dans le monde,

- l’accélération et l’agilité pour toujours plus d’innovation

- la réduction drastique du Time To Market : mois –> jours

Antoine Larmanjat, CIO, Euler Hermes (assurances credits B2B) nous parle maintenant de la manière dont ils ont abordé l’utilisation du cloud AWS.

Leurs énormes besoins de temps réel sur de grosses volumétries (demandes de limits de la part de leurs clients), ainsi que les demandes d’API auxquelles se connecter justifie grandement leur approche “Cloud First” et “No Lift & Shift”.

Tout cela devenant possible grâce à la gestion complète de leur infrastructure as code, et la priorité mise sur le serverless, devant les containers. Les machines virtuelles devenant le dernier recours.

Pour terminer cette keynote d’ouverture, Florian Douetteau, Co-founder & CEO, Dataiku insiste sur l’importance des datas et de leur analyse pour mieux comprendre ce qu’il se passe à tous les niveaux. C’est par exemple un prérequis à la gestion de son Capacity Planning et au scaling de ses ressources.

L’autoscaling du workload avec Kuberenetes

Comment répondre efficacement et rapidement aux changements de workload sur nos applications ?

L’évolution des façons d’exécuter les applications va toujours vers une plus grande souplesse : Architectures monolithiques [fa=fa-long-arrow-right /] Machines virtuelles [fa=fa-long-arrow-right /] Containers

La gestion des clusters de containers par Kubernetes apporte des solutions pour autoscaler et adapter sa puissance en fonction de la demande utilisateur, grâce à son module HPA (Horizontal Pod Autoscaler).

Comme cela a été rappelé lors de la keynote, le point d’entrée du sizing de nos clusters est bien évidement l’analyse de métriques variées, et le module Kubernetes HPA permet (depuis la version 1.10) de les utiliser qu’elles soient internes ou externe au cluster.

Dans ce contexte, la bonne pratique est de se concentrer sur les 4 Golden Signals:

- la latence (le temps de réponse du service)

- le trafic (le volume de données échangées)

- les erreurs (leur nombre, leur criticité)

- la saturation (la charge des services)

VMWare dans le cloud AWS avec VMWare Cloud

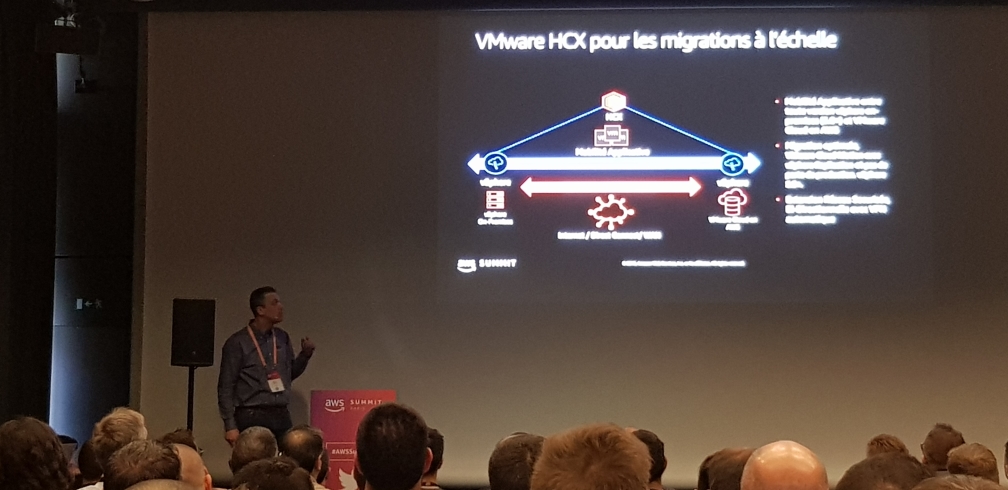

Lancé en 2017, VMWare Cloud permet d’étendre la solution VMWare vers le cloud AWS en unifiant la vision des VCenters on-premise et dans le cloud.

La partie SDDC (Software-Defined Datacenter) est géré par VMWare directement et nécessite un ensemble de droits IAM dans notre compte AWS pour lui pouvoir gérer les ressources. En effet, c’est la solution de VMWare qui va piloter les instances, le stockage et les interfaces réseau de notre infrastructure AWS afin que nous puissions lancer les machines virtuelles dessus.

Une fois l’infrastructure sous-jacente en place, le module HCX permet l’abstraction des ressource on-premise et cloud pour faciliter la fluidité des migrations, et notamment vMotion. Grace à cette couche d’abstraction, l’hybridation devient une simple formalité. Il est par exemple possible de déplacer à chaud et avec un impact réduit (baisse de performances, latence mais sans interruption de service) les machines virtuelles vers le cloud.

Attention !

L’utilisation de VMotion pour déplacer les VM entre le cloud et les infrastructure on-premise n’est possible qu’à travers un lien DirectConnect.

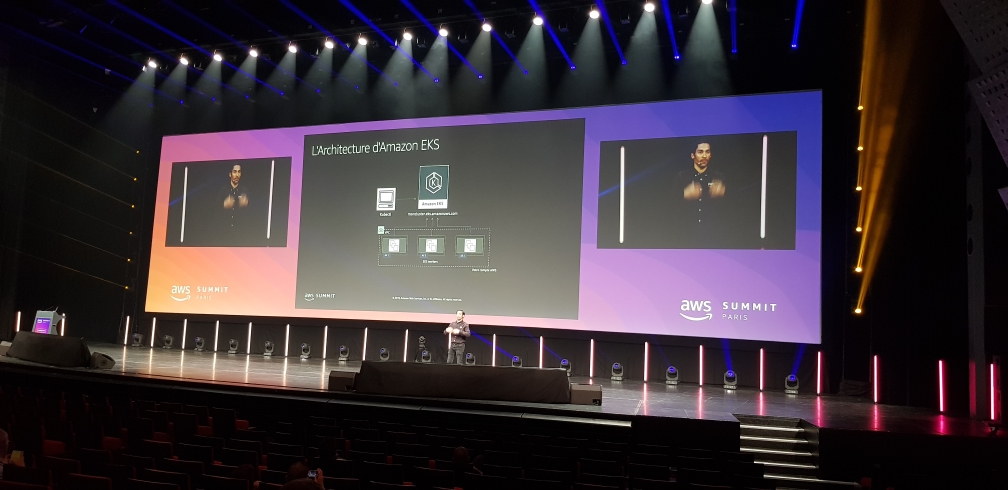

L’implémentation Kubernetes sur AWS avec EKS

Pour la gestion des conteneurs Docker en mode cluster, Kubernetes est devenu ces dernières années LA référence. AWS a donc en toute logique lancé son service de cluster Kubernertes (EKS) à la demande à coté de ses offres précédentes (ECS, Fargate).

Les cluster peuvent ainsi être créés via les templates CloudFormation, ou via l’utilitaire en CLI eksctl.

L’autoscaling est possible sur 2 niveaux :

- au niveau pods grace au module HPA

- au niveau des nodes accueillant les podes grace aux groupes de scaling

Concernant le versionning de la brique Kubernetes, AWS permet la gestion de la version utilisée par les clusters en mode blue/green ou directement “à chaud” en modifiant l’AMI dans le template cloudformation qui sera donc appliqué en rolling release. AWS gère 3 versions de Kubernetes à un instant t (1.10, 1.11 et 1.12 actuellement), les versions plus récentes étant en cours d’implémentation (1.13 et 1.14).

Dans le même temps, AWS a créé le plugin vpc-cni pour Kubernetes afin de gérer l’association des interfaces ENI aux nodes et l’association des IP (ip secondaires des nodes) aux pods de manière intégrée.

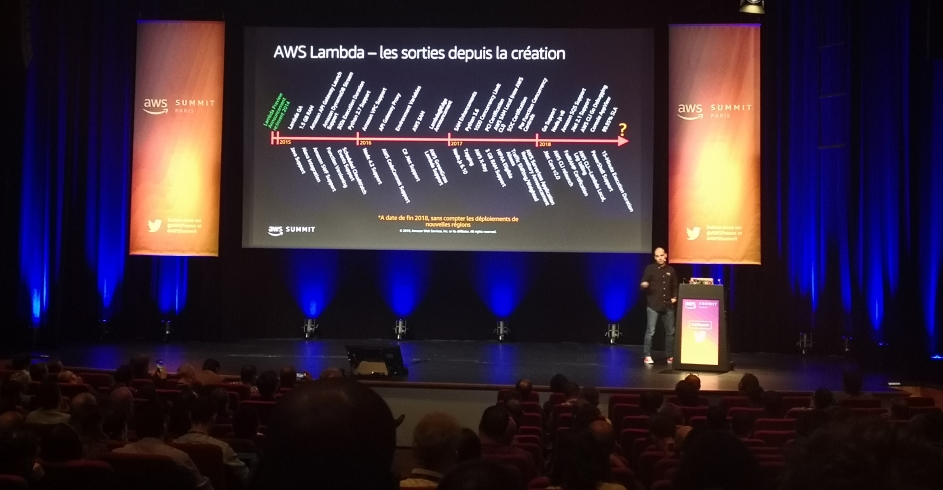

Le Serverless à travers Lambda

Comme vous avez pu le constater de nombreux services sont proposés chez AWS. Dans son grand catalogue, un service à retenu notre attention, Lambda. Comme ses voisins EKS et EC2, il a pu trouver de vrais fans chez les petites, moyennes et grandes entreprises.

Sa capacité à pouvoir exécuter des scripts sans provisionnement de machine ou de container, a séduit un grande partie du public. Ils ont vu en celui-ci un bon moyen de réduire leurs coûts et une excellente solution pour la gestion d’application sans avoir à s’occuper de l’infrastructure.

Le service est relativement simple à utiliser. Vous déployez votre code sur la plateforme et il sera exécuté par un “trigger” configuré (dépôt d’un fichier dans un bucket S3, événement en base de données, etc…). Le grand avantage de cette technique, est que vous ne payez que ce que vous utilisez en ressource pendant son exécution, ni plus ni moins.

Depuis ses débuts en 2015, le service n’a pas cessé de s’améliorer :

- Il peut maintenant exécuter un grand nombre de langage (python, java, ruby, …)

- La configuration des triggers offre de plus en plus de possibilités, dont celle du ChatOps qui est particulièrement remarquable

- La possibilité de chainer plusieurs scripts et configurer leurs enchainements par des conditions

- La possibilité de tester sur votre IDE (VisualStudio Code, Intellij) en local les scripts dans un éco système iso lambda grâce à de nombreux plugins officiels.

Ce projet à un bel avenir devant lui, et je vous conseille de le suivre des près !

Keynode de cloture

C’est maintenant l’heure de finir en beauté avec Julien Groues, Country Manager France, AWS.

L’accent est mis sur les startups et l’innovation qu’elles engendrent grâce aux services proposés par AWS.

Sont aussi rappelé les piliers de toute transformation réussie :

- la maîtrise des impacts métiers

- la réduction des risques

- les équipes

- les bénéfices financiers Et c’est bien sûr aussi valable pour les transformations cloud ou DevOps.

Enfin, sont remis les différents prix décernés cette année :

- La Startup Architecture of the Year : Klap

- Les gagnants du GameDay de cette année : alterway, comexport et wescale

- Le gagnant de la DeepRacer League à Paris qui pourra défendre ses chances lors de la prochaine messe Re:Invent à Las Vegas.

Et pour finir…

Cette journée à l’AWS Summit Paris 2019 aura été riche en contenu, que ce soit les via les keynotes ou les différentes sessions techniques.

AWS reste de loin l’un des plus avancé en terme d’offre dans le domaine du cloud public et nous montre aujourd’hui qu’ils ont su garder leur momentum en terme d’innovation.

Il suffit de regarder le rythme de lancement de nouveaux services (je vous invite d’ailleurs à suivre toutes les nouveautés sur la page https://aws.amazon.com/new/) et d’amélioration constante des services existants. On sent bien l’effort mis sur les sujets les plus “demandés” : le Machine Learning, Kubernetes, la facilité et la fluidité de la migration dans le cloud, …

J’ai hâte de voir les évolutions qui nous attendent d’ici la prochaine édition !

Pour ceux qui souhaitent revivre les différentes sessions, elles sont disponibles (certaines avec leur support) ici : https://aws.amazon.com/fr/events/summits/paris/contenu/